【猎云网(微信号:ilieyun )】7月24日报道(编译:郑意)

)】7月24日报道(编译:郑意)

高级的自然语言处理系统,比如OpenAI的GPT-2,可以写出人性化的语言,这一点令人印象深刻。然而,这样的人工智能的语言往往缺乏说服力和连贯性。其最显著的特点就是他们难以写出令人信服的作品——人工智能生成的故事往往是通用的,缺乏上下文。

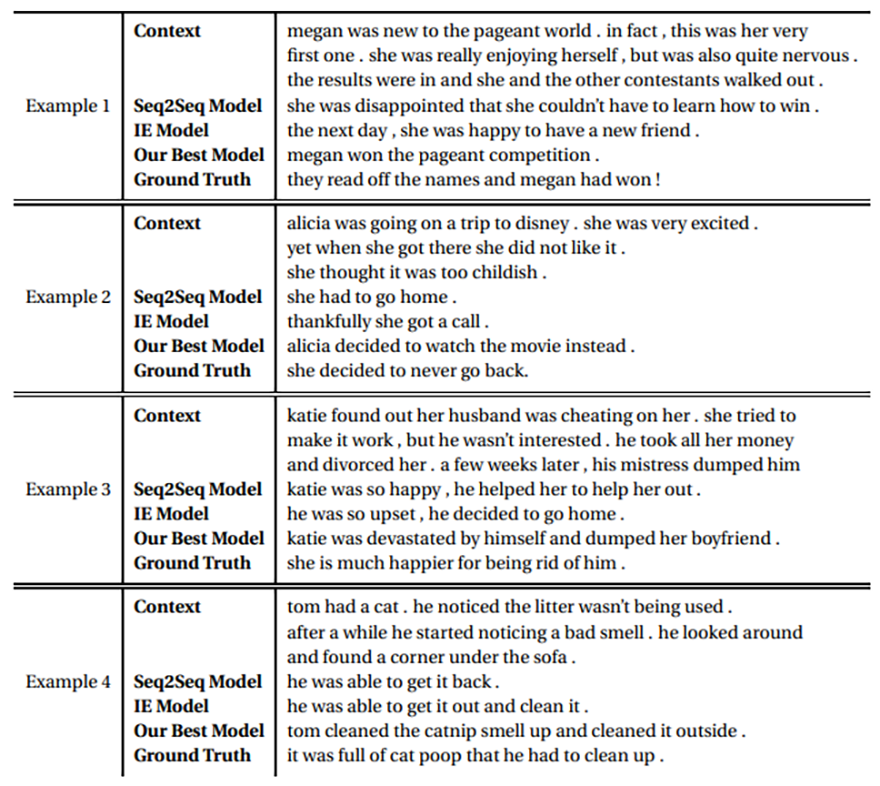

为解决这一问题,卡内基梅隆大学计算机科学学院的科学家们设计出一种方法,即为一个给定的故事创造更多“多样化”的结尾。他们表示,研究的关键是训练人工模型把注意力集中在故事的重要短语上,促进非通用词的生成。

“故事情境由连接人物和事件的一系列句子构成。这项任务具有挑战性,因为它需要对上下文中的角色,事件和对象进行建模,然后根据它们生成连贯且合理的结尾。概括事件和实体的语义以及它们在不同故事中的关系是一项非常重要的任务,”合著者写道,“我们的研究表明,两者的结合会带来更多样、更有趣的结局。”

团队利用seq2seq模型(一种长短期记忆递归神经网络架构,能够学习依赖关系),并创建符合目标故事情境的文字的数学表示,学习这些文字之间的关系,将他们转化为人类可读的文本。为了整合故事上下文中的关键短语,研究人员使用了一种名为RAKE的算法,该算法根据单词的出现频率和共现度为短语分配分数,然后根据相应的分数对短语进行手动排序,并将低于一定阈值的短语丢弃。

为了使模型能够生成更丰富的结尾,科学家们通过ROCStories数据集升级了他们的模型,该数据集包含超过50,000个五句话的故事。为了评估该模型,他们使用DIST算法计算得出不重复的一元模型(来自给定文本或语音样本的n个项目的连续序列)、二元模型(一对连续写单位如字母、音节,或文字)和三元模型(三个连续写单位)的数量,并将它们与一元、二元和三元模型的总数量相除。

在另一项测试中,他们训练谷歌的BERT完成开源故事填空任务,让BERT在给定两个选项的情况下选择正确的故事结尾,从而将模型与基线进行比较。

那么人工智能的表现如何呢?显然想拿到普利策奖是不可能了。虽然它在DIST测试中名列前茅,且故事完形填空的正确率达到了72%,但它偶尔也会给出一些荒谬的结尾,比如“凯蒂被自己搞得崩溃了,甩了男友”,或者不正确的代词(“凯蒂”、“他自己”)。

研究人员承认,需要进一步的研究来确保输出“语义和象征层面上的上下文”,并且它们在逻辑上是合理和一致的。尽管如此,他们声称他们已经“定量地”和“定性地”表明他们的模型能够超越基线,实现“有意义的”改进。